AI検索最適化(GEO/LLMO)ツールにモデル別にブランド評価の差を可視化する新機能を追加

株式会社CINC(本社:東京都港区、代表取締役社長:石松友典、以下CINC)は、独自開発のAI検索最適化(GEO/LLMO)ツールに、「どの企業・ブランドが推奨されているか」を生成AIのモデル別・カテゴリ別に可視化し、定量的に分析できる新機能を追加いたしました。

本機能により、ブランドのプレゼンス(存在感)や評価構造を生成AIのモデル別・カテゴリ別に明らかにし、戦略策定に活かすことができます。

<新機能実装の背景>

CINCでは、AI検索最適化コンサルティングサービスの提供にあたり、自社開発のツールを活用し、分析業務の効率化と標準化を図っています。

コンサルティングを行う上では、現状調査が欠かせません。しかし、生成AIの回答内容からブランドの言及状況を集計し、分析するには多くの工数がかかります。

また、調査を進めていく中で、同じプロンプトでもChatGPTやPerplexityなど生成AIのモデルによって、推奨するブランドや評価の文脈に違いがあることも明らかになっています。そのため、生成AIをひとくくりで捉えてしまうと差分が見えなくなり、優先して対策が必要なモデルや、モデルごとに評価されている文脈を把握しづらくなってしまいます。

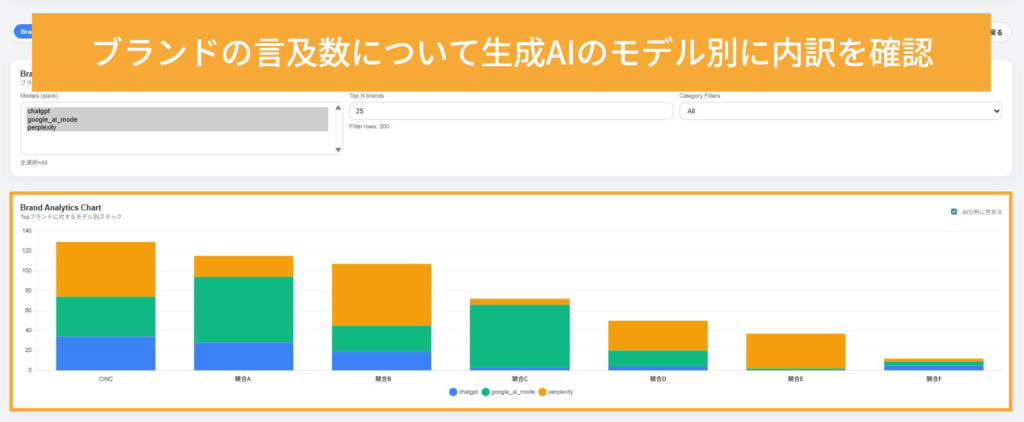

こうした前提を踏まえ、現場のコンサルタントからのフィードバックを基に、生成AIの回答データを集計し、ブランドの言及数をモデル別・カテゴリ別にグラフで確認できる機能を新たに開発、実装しました。

本機能により、優先的に対策すべき生成AIモデルの判断が可能となるほか、モデルごとに評価されているカテゴリを解像度高く把握することができます。

<新機能の主な内容>

今回新たに実装した機能の概要は以下のとおりです。

| 機能 | 概要 |

|

ブランド分析 |

生成AIの回答内で特に言及数の多いブランドを集計して表示します。ChatGPTやPerplexityなど、生成AIのモデルごとに色分けした棒グラフで確認できます。 |

|

モデル別構造分析 |

生成AIのモデルごとにブランドの言及数を集計し、カテゴリ別に色分けした棒グラフで表示します。カテゴリごとのフィルタリングも可能です。 |

|

AIチャット |

選択したグラフのデータを基に、AIチャットと対話しながら分析を進めることができます。 |

<新機能のポイント>

1.生成AIのモデル別にブランドの言及傾向を確認

「ブランド分析」では、生成AIのモデル別に「どのブランドが推奨されているか」を確認できます。例えば「ChatGPTでは推奨されているが、Perplexityではあまり推奨されていない」などのように、生成AIのモデル間における評価の違いを把握することが可能です。

2.モデル×カテゴリ別に、ブランドの強みと弱みを把握

全体像を把握した後は、各生成AIモデルが「どのカテゴリ」で「どのブランド」を推奨しているのか、構成比を確認できます。例えば、『Perplexityは「商品の品質」の文脈でA社を多く推奨しているが、「機能」の文脈ではB社を推奨している』などのように、カテゴリごとの評価の違いを把握する際に活用します。

3.分析に迷ったときは、AIチャットに壁打ち

データの解釈に迷った場合は、AIチャットと対話しながら分析を進めることも可能です。分析したいグラフを選択したうえで、「モデルごとの傾向の違いを教えてください」などと質問すると、AIチャットがデータを基に回答します。

本ツールは、生成AIの回答アルゴリズムの変化に迅速に対応するとともに、コンサルティング業務の効率化および提供価値の向上を目的として継続的にアップデートを行っています。今後、コンサルティングサービスをご契約中のお客さまにも順次提供予定です。

CINCでは今後も、AI検索最適化(GEO/LLMO)ツールの機能開発に注力し、お客さまの課題解決と成果創出に貢献してまいります。